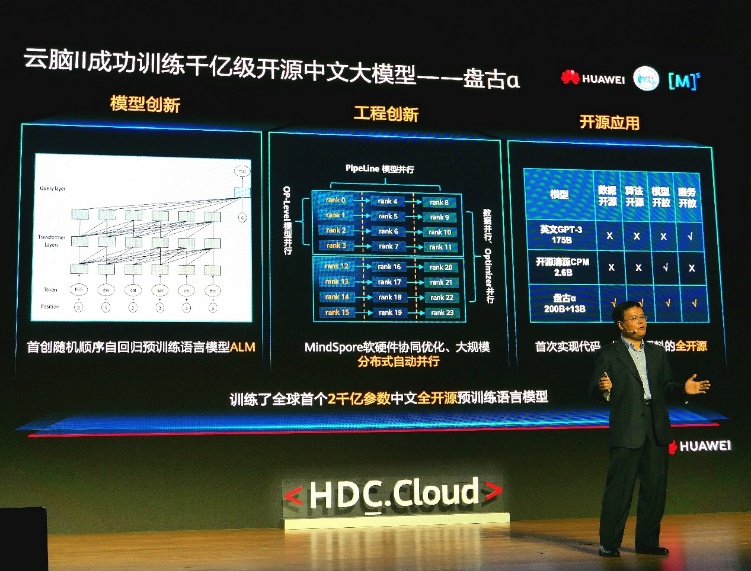

2021年4月26日,在深圳召开的HDC全球开发者大会上,北京大学信息科学技术学院计算机科学技术系教授、鹏城实验室鹏城云脑大科学装置技术总体负责人田永鸿博士发布了业界首个全开源2000亿参数中文预训练语言模型“盘古α”。这是国产全栈式AI基础设施支持2000亿级超大规模语言模型训练的第1次,探索并验证了国产E级智算平台在软硬件协同优化、大规模分布式并行训练等核心关键技术的可行性。

田永鸿教授介绍,基于鹏城云脑II大科学装置,“盘古α”形成了国产自主可控的通用超大规模分布式训练基座及相关核心技术,由北京大学田永鸿教授和曾炜副研究员带领师生联合鹏城实验室、诺亚方舟实验室和Mindspore团队组建的技术联合攻关团队,经过数月的艰苦工作,开发完成了“盘古α”模型,模型在16个下游任务中大部分指标优于SOTA模型,其中零样本学习任务11个任务领先,单样本学习任务12个任务领先,小样本学习任务13个任务领先。代码、模型、评测数据集正同步在OpenI启智社区全面开源开放,训练语料和在线服务体验将在测试评估优化后开源开放。

田永鸿教授介绍“盘古α”

田永鸿教授表示,为了训练“盘古α”这样的超大规模参数的模型面临诸多挑战,联合攻关团队做出许多创新:首先构建了一个大规模中文训练语料收集与自动化处理平台,从近80TB多源文本数据中通过过滤、查重和模型评估提炼了近1.1TB高质量的训练语料,为超大规模语言模型的训练奠定了很好的基础;从模型本身上提出了随机顺序自回归训练的模型ALM,提升了算法小样本学习能力;MindSpore的多维度混合自动并行从工程上大幅提升了在大规模集群上自动训练的效率;在OpenI启智社区实现“盘古α”数据、算法、模型和服务的逐步全面开源开放,希望以启智开源社区为载体,集众智、聚众力,吸引开发者共同参与到模型的压缩轻量化和应用创新工作中,不断探索“盘古α”模型的强大潜力。

OpenI启智社区是在国家实施新一代人工智能发展战略背景下,新一代人工智能产业技术创新战略联盟(AITISA)组织产学研用协作共建共享的开源平台,旨在以鹏城云脑重大科研基础设施及Trustie软件开发群体化方法与平台为基础,全面推动人工智能领域的开源开放协同创新。“盘古α”的全面开源开放旨在通过以大模型为基础,在探索通用智能的道路上不断前进,打通大规模AI设备集群和通用性软硬件生态协同的屏障,形成国产自主可控的通用超大规模分布式训练基座及相关核心技术。同时通过支持开源开放、赋能相关产业界的应用创新和基础研究的不断协同进步。

“盘古α”开源地址:https://git.openi.org.cn/PCL-Platform.Intelligence/PanGu-Alpha