计算机学院多篇论文入选系统领域顶级会议USENIX ATC 2024

USENIX ATC全称为USENIX年度技术大会(USENIX Annul Technical Conference),是计算机系统方向最重要的国际会议之一,在国际上享有极高的学术声誉,也是CCF推荐的A类会议。自1992年以来,已成功举办30多届,吸引了来自全球的顶级名校、科研机构和企业投稿。本届会议共收到488篇论文投稿,录用77篇,录用率仅为15.8%,为近年最低录用率。

计算机学院此次被USENIX ATC录用的4篇论文,研究成果涵盖多个领域。以下是论文简要内容介绍:

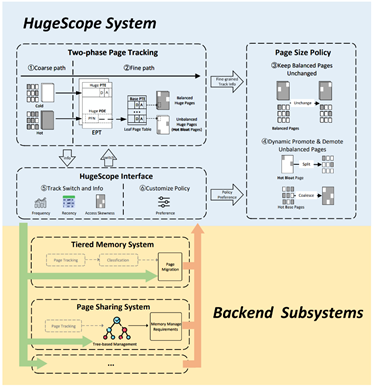

一、面向虚拟化场景的大页热膨胀解决框架

大页被广泛用于虚拟化环境以提升两级地址翻译效率。然而,激进地使用大页会导致页面热膨胀的问题,即对于一个倾斜访问部分小页区域的大页,hypervisor会错误地将其识别为一个高热度的大页。在非虚拟化环境下的分层内存管理场景已经有方案解决热膨胀问题,但是需要在准确性、性能和硬件修改三个方面进行权衡。事实上,在虚拟化环境中,热膨胀会对更多的应用场景产生性能和资源利用率的影响。针对此挑战,论文“Taming Hot Bloat Under Virtualization with HugeScope”提出了首个针对于虚拟化环境解决热膨胀的框架HugeScope。论文的核心思想是利用虚拟化带来的第二级地址空间稳定的特性,使得EPT极少被修改,并且总是通过稳定的软件接口进行访问。HugeScope通过1)利用不一致地拆分EPT页表页完成低开销、高准确率的小页粒度监控机制并在EPT的访问接口添加代码钩子保证安全,进而获得大页面中小页粒度的访问情况; 2)根据页面的frequency、recency和skewness抽象出系统的热页膨胀率,全面且动态地决策和调整页面的大小;3)提供一套模块化接口以支持不同的管理子系统。与现有的机制相比,HugeScope能够在分层内存场景带来61%的性能提升,在页面共享场景带来41%内存资源共享提升。该论文第一作者为计算机学院2021级博士生李传东(导师为汪小林、罗英伟教授),作者包括华为公司沙赛博士、北京大学曾洋卿同学、杨翕然同学、罗英伟教授、汪小林教授、密歇根理工大学王振林教授、EPFL/北京大学周迪宇助理教授。

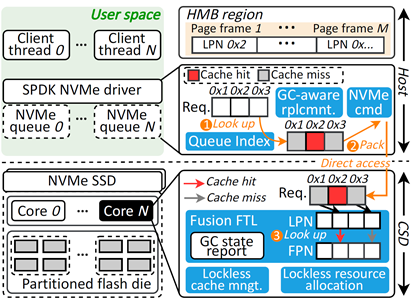

二、软硬件协同处理的用户态页面缓存

存储软件栈通常会集成页面缓存(Page Cache)管理模块,该模块将热数据缓存在主存中来加速应用的I/O访问。然而,现有的页面缓存管理模块均根据以主机为中心的原则而设计,这种设计原则使得页面缓存管理模块存在CPU开销、通信开销和SSD垃圾回收干扰等问题。为了解决这些挑战,论文“ScalaCache: Scalable User-Space Page Cache Management with Software-Hardware Coordination”提出了一种软硬件协同处理的用户态页面缓存模块ScalaCache。具体来说,为了减少主机CPU资源的开销,ScalaCache将缓存管理卸载到计算型固态硬盘(Computational SSD, CSD)中,并进一步合并缓存管理模块中的索引结构和CSD固件中的闪存转换层,从而实现轻量的缓存管理。为了进一步提高性能可扩展性,ScalaCache设计了一个无锁资源管理框架,允许多个 CSD core并发管理缓存。此外,ScalaCache聚合多个CSD的计算能力来实现基于CSD数量的性能可拓展性。ScalaCache还通过简化I/O控制路径来降低通信开销,同时设计SSD垃圾回收可感知的替换策略来减轻垃圾回收引起的干扰。与Linux内核页面缓存和最先进的用户态缓存管理模块相比,ScalaCache分别提升了3.38倍和1.70倍的带宽。该论文第一作者为计算机学院2023级博士生彭力,导师及通讯作者为张杰助理教授,合作作者包括华中科技大学周游副研究员、中科院计算所王晨曦副研究员、厦门大学李乔副教授与华为程传宁博士。

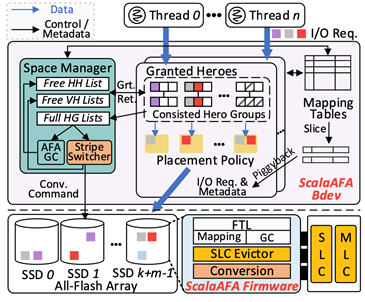

三、基于软硬协同设计的用户态全闪存阵列引擎

相较磁盘,闪存因其高性能的特点近年来被广泛应用到数据中心,高性能计算和移动设备中。但单个的闪存已无法满足日益增长的对可靠性,大容量和高吞吐的要求。使用多个闪存搭建全闪存阵列,利用条带化技术提高带宽,同时使用校验和提供容错是解决这个问题的可行解。但是,现有的闪存阵列框架存在较大的软件开销,这成为了限制全闪存阵列性能和可扩展性的关键因素。论文“ScalaAFA: Constructing User-Space All-Flash Array Engine with Holistic Designs”提出使用软硬协同设计的方式来解决这一问题。一方面,将全闪存阵列引擎整合到用户态中,同时设计无锁的线程间同步方案以减少存储软件栈开销。另一方面将校验生成的任务去中心化,并卸载到闪存中,利用闪存自带的计算资源进行计算。同时,ScalaAFA设计了一个创新性的数据布局方案,巧妙地规避了校验生成中数据移动的开销。ScalaAFA还利用闪存的架构优势解决了全闪存阵列的元数据持久化和写放大问题。该论文的第一作者为计算机学院2022级博士生易舒舒,其导师及论文通讯作者为张杰助理教授,作者还包括北京大学潘修睿同学、厦门大学李乔副教授、毛波教授,中科院王晨曦副研究员,阿里巴巴李强博士以及KAIST的Myoungsoo Jung副教授。

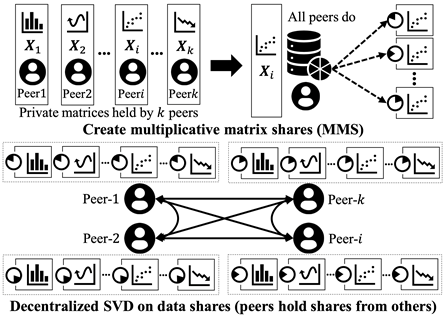

四、高效的去中心化联邦奇异值分解

联邦奇异值分解(SVD)是许多分布式应用的基础。例如分解多方持有的大规模基因数据进行全基因组关联性分析(GWAS),分解银行和互联网公司持有的大规模用户画像进行特征降维(PCA)和线性回归建模(LR),分解多方持有的大规模文档数据进行潜在语义分析(LSA)等。但现有联邦SVD方案要么依赖外部服务器,带来极大的安全隐患;要么使用同态加密技术来摆脱外部服务器(即去中心化),但由于大量计算和通信开销而导致效率显著下降。本文提出Excalibur,一个高效、去中心化的联邦SVD系统。Excalibur的核心设计包含两部分。首先,Excalibur提出了一种轻量级、去中心化的矩阵保护方法,以减少由加密操作带来的性能下降。此外,通过对去中心化SVD系统的设计空间进行通信定量分析,设计了一个通信高效的去中心化SVD工作流,大幅度优化了通信性能。为了验证Excalibur的效率,我们实现了一个功能完备的原型系统,并对基于SVD的实际应用进行了广泛测试。结果显示,Excalibur不仅移除了外部服务器,而且在不同形状的十亿级矩阵数据上,性能比当前最先进的服务器辅助SVD系统快3∼6倍。此外,Excalibur吞吐量比最先进的同态加密SVD系统大23,000多倍。该论文第一作者为香港科技大学博士生柴迪,作者包括香港科技大学陈凯教授和杨强教授、北京大学计算机学院王乐业助理教授等。