一、成果简介

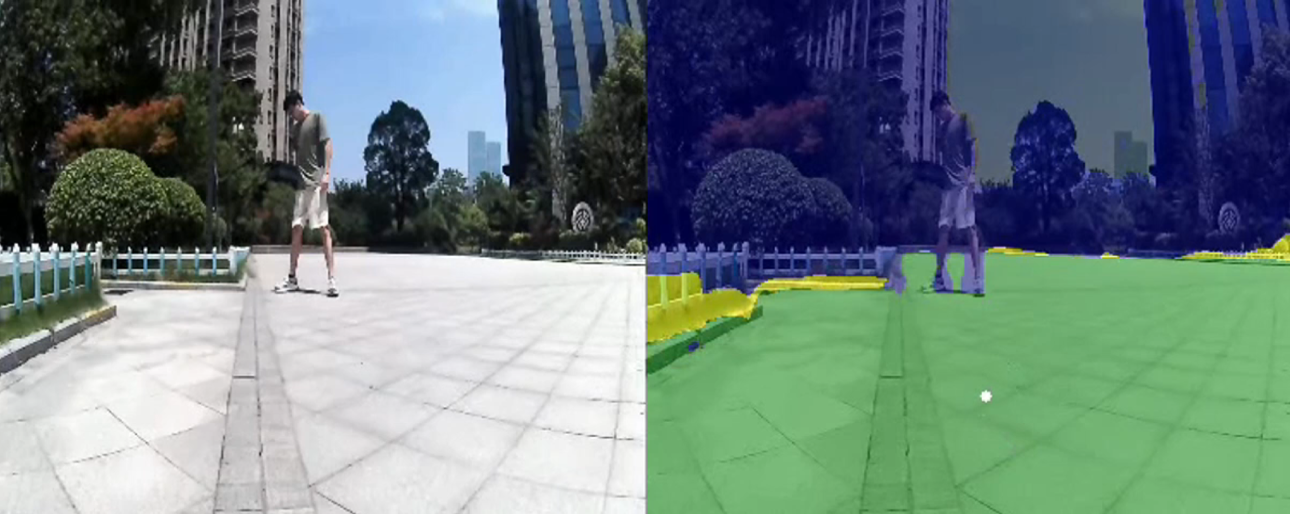

1. 开放场景视觉导航:研究机器人的视觉-语义-导航(Vision-Language-Navigation,VLN)端侧大模型,让机器人在室内外开放世界中实现全域全地形自主导航。仅需要单个普通摄像头,无需提前建图,即可赋能机器人像人眼视觉一样看懂眼前世界自主移动并自主避障,并可以结合视觉和语义与用户进行交互式导航。支持自由导航、跟随导航、语义导航和地图导航四种模式。

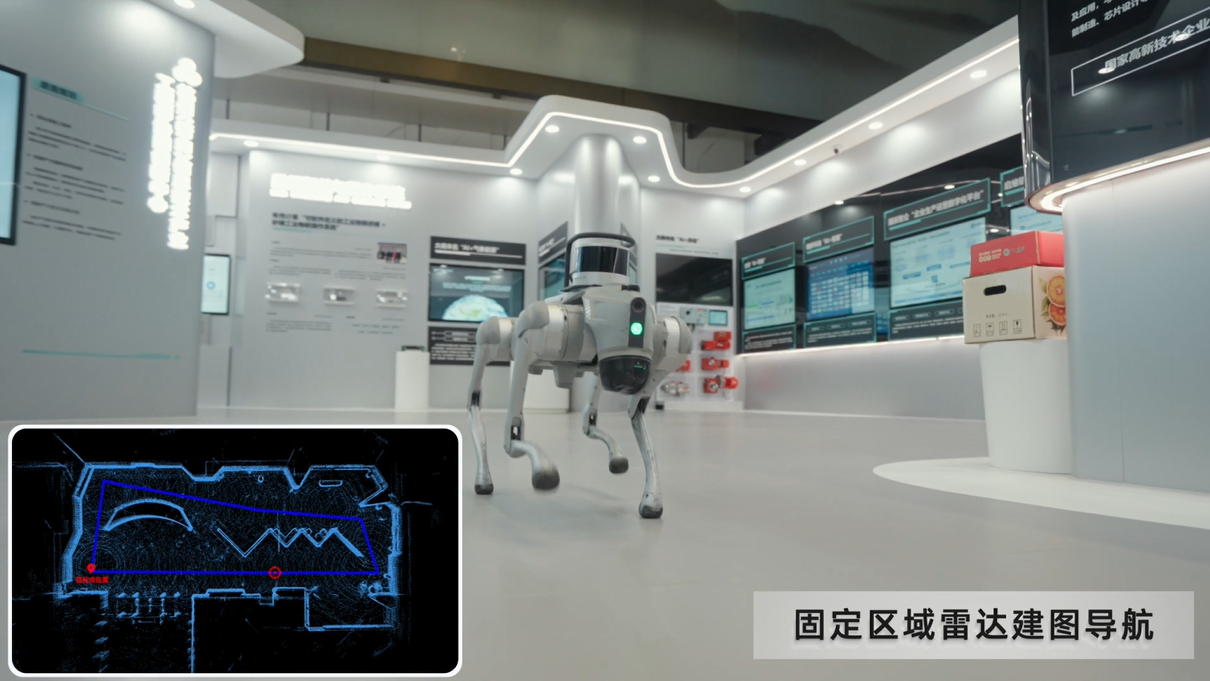

2. 固定场景SLAM导航:基于2D激光雷达、3D激光雷达、视觉摄像头等进行建图定位与导航(SLAM),适用于固定区域场景机器人自主导航,如室内、工厂、园区等。在建图后,机器人可以按照预设路线自由移动并自主避障。

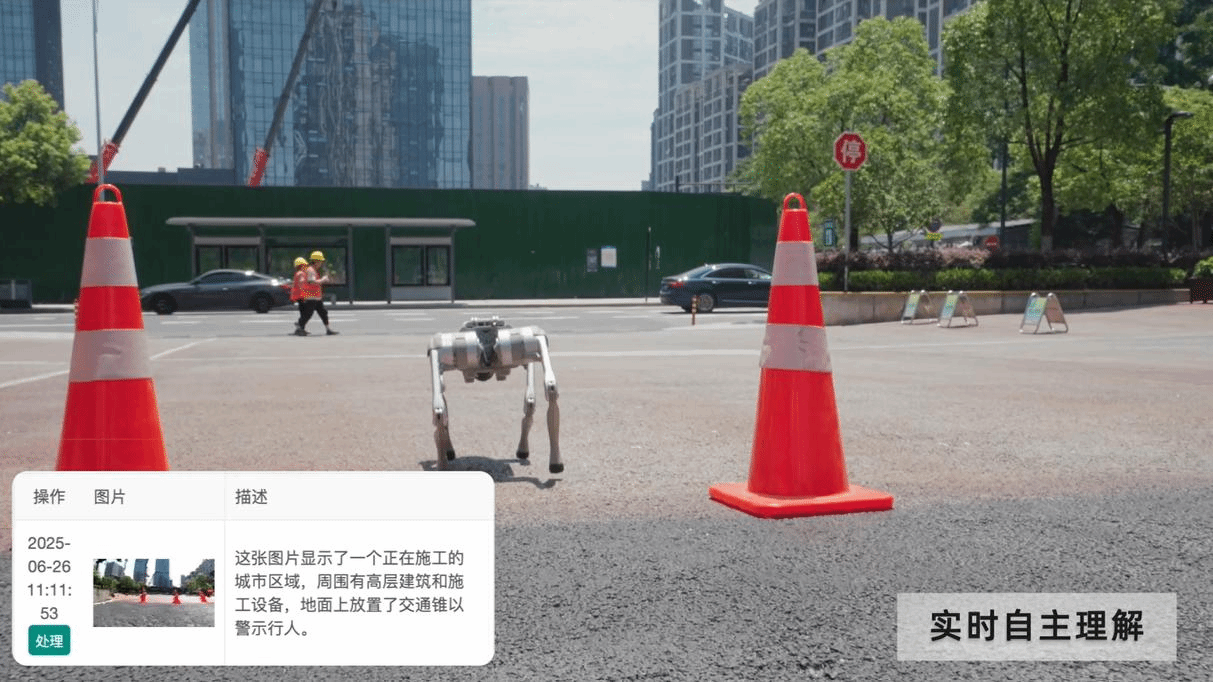

3. 视觉语义理解与检测:基于多模态大模型与多模态小模型协同的方案构建对摄像头、机器人、无人机等视频流的实时理解,将视频画面转换为文字描述自动形成摘要,并可检测制定类型的对象、行为或事件。技术核心点在于以低复杂度低算力成本实现泛化视觉理解功能。

二、应用领域和市场前景

所有需要移动能力或视觉理解能力的机器人、无人车、电子产品等,如人形机器人、机器狗、无人车、陪伴类机器人、AI玩具等各类产品。

三、合作方式

技术服务及咨询、合作开发、技术入股、招商引资、企业合作等。

对接方式

1.合作意向方联系北京大学计算机学院产学研合作办公室;

2.产学研合作办公室沟通了解意向方情况;

3.会同成果完成团队与意向方共同研讨合作方案。

北京大学计算机学院产学研合作办公室

邮箱:hecheng1213@pku.edu.cn

未经授权,请勿转载